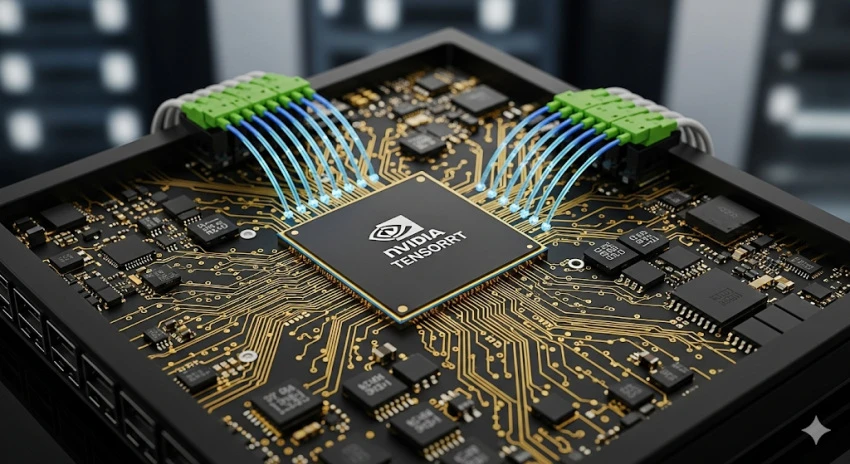

NVIDIA TensorRT: راز سرعت استنتاج مدلهای هوش مصنوعی 🚀

در دنیای پیشرفته امروز، دیگر صرفاً آموزش مدلهای هوش مصنوعی کافی نیست. چالش اصلی، استقرار (Deployment) این مدلهای قدرتمند در دنیای واقعی است؛ جایی که سرعت، کمترین تأخیر (Latency) و بیشترین بازدهی (Throughput) حرف اول را میزنند. آیا مدل یادگیری عمیق شما روی کاغذ عالی عمل میکند، اما در عمل به دلیل سرعت پایین، ناکارآمد است؟ 😟 در هوش مصنوعی، سرعت و کارایی در مرحله استنتاج (Inference) به اندازهی دقت اهمیت دارد. یک مدل بزرگ و پیچیده، اگر نتواند در زمان واقعی و با هزینهی منطقی به درخواستها پاسخ دهد، عملاً کاربرد خود را از دست میدهد. اینجاست که NVIDIA TensorRT به عنوان ابزاری قدرتمند وارد میدان میشود تا فرآیند استنتاج شبکههای عصبی عمیق را روی پردازندههای گرافیکی (GPU) بهینهسازی و شتابدهی کند. با ما همراه باشید تا این ابزار حیاتی را بشناسید و دانش لازم برای تبدیل مدلهای سنگین به موتورهای استنتاج سریع و کارآمد را کسب کنید.

چرا بهینهسازی استنتاج حیاتی است؟ 🤔

دنیای هوش مصنوعی با سرعت سرسامآوری در حال پیشرفت است و مدلها روز به روز بزرگتر و پیچیدهتر میشوند. این پیچیدگی، چالشهای جدیدی را در مرحلهی استقرار و استفاده عملی از این مدلها ایجاد میکند. تصور کنید یک دستیار صوتی فوقالعاده هوشمند ساختهاید، اما پاسخگویی آن چند ثانیه طول میکشد! یا یک سیستم تشخیص عیب در خط تولید، به دلیل کندی، نتواند به موقع مشکل را شناسایی کند. این تأخیرها و کاهش بازدهی، میتواند کل زحمات شما را بیثمر کند.

مفهوم کلیدی: استنتاج (Inference) در مقابل آموزش (Training) 🧠

آموزش یک مدل هوش مصنوعی، فرآیندی زمانبر و نیازمند منابع محاسباتی بالاست که در آن مدل الگوها را از دادهها یاد میگیرد. اما استنتاج، مرحلهی استفاده از مدل آموزشدیده برای پیشبینی روی دادههای جدید است. در بسیاری از کاربردهای واقعی، مانند خودروهای خودران، پردازش آنی تصویر یا سیستمهای تشخیص صدا، تأخیر در استنتاج میتواند عواقب جدی داشته باشد. به همین دلیل، بهینهسازی این مرحله، حیاتی است.

نقش GPU در سرعت بخشیدن به استنتاج ⚡

پردازندههای گرافیکی (GPU) به دلیل معماری موازی خود، برای انجام محاسبات سنگین و تکراری شبکههای عصبی، بسیار کارآمدتر از CPU ها عمل میکنند. استفاده از GPU در مرحله استنتاج، میتواند سرعت پردازش را به طور چشمگیری افزایش دهد. با این حال، حتی استفاده از GPU نیز بدون بهینهسازیهای تخصصی، ممکن است نتواند نیازهای سرعت و تأخیر را برآورده کند.

آشنایی عمیق با NVIDIA TensorRT 💡

TensorRT یک پلتفرم توسعهی قدرتمند از NVIDIA است که به شما کمک میکند تا مدلهای یادگیری عمیق خود را برای اجرای با حداکثر کارایی روی سختافزارهای NVIDIA بهینه کنید. این ابزار با انجام تکنیکهای مختلف بهینهسازی، سرعت استنتاج را به طور قابل توجهی افزایش داده و مصرف حافظه را کاهش میدهد. TensorRT از طیف وسیعی از فریمورکهای محبوب یادگیری عمیق مانند TensorFlow، PyTorch و ONNX پشتیبانی میکند.

چگونه TensorRT مدل شما را بهینه میکند؟ ⚙️

TensorRT از چندین تکنیک برای دستیابی به عملکرد بالا استفاده میکند:

تقطیر (Quantization): کاهش دقت عددی وزنها و فعالسازیهای شبکه (مثلاً از FP32 به FP16 یا INT8) بدون افت قابل توجه در دقت مدل. این کار حجم مدل را کاهش داده و محاسبات را سریعتر میکند.

تبدیل لایهها (Layer Fusion): ادغام چندین لایه عملیاتی به یک عملیات واحد. به عنوان مثال، ترکیب یک لایه کانولوشن، یک لایه Batch Normalization و یک لایه ReLU در یک عملیات. این کار سربار محاسباتی را کاهش میدهد.

بهینهسازی زمان اجرا (Kernel Auto-Tuning): انتخاب بهترین الگوریتمها (kernels) برای انجام محاسبات روی سختافزار هدف. TensorRT با تست و ارزیابی گزینههای مختلف، بهینهترین kernel را برای هر عملیات انتخاب میکند.

رزولوشن پویا (Dynamic Tensor Memory): مدیریت هوشمندانهی حافظهی GPU برای کاهش هدررفت و افزایش بهرهوری.

اجرای موازی (Parallelization): بهرهگیری حداکثری از قابلیتهای پردازش موازی GPU.

کدام مدلها با TensorRT سازگار هستند؟ 🎯

TensorRT با انواع شبکههای عصبی عمیق، از جمله شبکههای کانولوشنی (CNN) برای بینایی ماشین، شبکههای بازگشتی (RNN) و ترانسفورمرها (Transformer) برای پردازش زبان طبیعی، سازگار است. شما میتوانید مدلهای آموزشدیده با فریمورکهایی مانند TensorFlow، PyTorch، Caffe و MXNet را به فرمت TensorRT تبدیل کنید.

فرآیند استفاده از TensorRT در عمل 🛠️

استفاده از TensorRT معمولاً شامل چند مرحله کلیدی است:

1. ذخیرهی مدل آموزشدیده: مدل نهایی آموزشدیده خود را در فرمت مورد پشتیبانی فریمورک (مانند SavedModel برای TensorFlow یا TorchScript برای PyTorch) ذخیره کنید.

2. تبدیل مدل: مدل را به فرمت TensorRT (معمولاً با استفاده از ابزارهای UFF یا ONNX Runtime) تبدیل کنید. این مرحله شامل بهینهسازیهایی مانند تقطیر و ادغام لایهها است.

3. ساخت موتور استنتاج: TensorRT یک “موتور استنتاج” (Inference Engine) مستقل ایجاد میکند که برای اجرا روی سختافزار هدف (GPU) بهینه شده است.

4. اجرای استنتاج: موتور استنتاج ایجاد شده را در برنامه خود بارگذاری کرده و برای پردازش دادههای جدید استفاده کنید.

این فرآیند به شما امکان میدهد تا از حداکثر توان GPU برای اجرای سریع و کارآمد مدلهای خود بهرهمند شوید.

کاربردهای عملی TensorRT در صنایع مختلف 🌐

TensorRT ابزاری حیاتی در بسیاری از حوزههای پیشرفته هوش مصنوعی است. سرعت و کارایی که این ابزار ارائه میدهد، امکان پیادهسازی راهحلهای نوآورانه را در مقیاس بزرگ فراهم میکند.

بینایی ماشین و پردازش تصویر 🖼️

در کاربردهایی مانند سیستمهای نظارتی هوشمند، تشخیص چهره، تحلیل تصاویر پزشکی، و خودروهای خودران، نیاز به پردازش لحظهای تصاویر و ویدئوها حیاتی است. TensorRT با شتابدهی به مدلهای تشخیص اشیاء، سگمنتیشن تصاویر و بازشناسی چهره، این امکان را فراهم میآورد تا این سیستمها بتوانند با دقت و سرعت بالا عمل کنند.

پردازش زبان طبیعی (NLP) 🗣️

مدلهای زبان بزرگ (LLM) و مدلهای پردازش زبان طبیعی، برای کاربردهایی مانند خلاصهسازی متن، ترجمه ماشینی، چتباتها و تحلیل احساسات، نیازمند سرعت استنتاج بالا هستند. TensorRT به بهینهسازی اجرای این مدلها کمک کرده و امکان ارائه پاسخهای سریعتر و تعاملات روانتر را فراهم میسازد.

رباتیک و سیستمهای خودکار 🤖

در رباتیک، تصمیمگیری سریع بر اساس درک محیط اطراف، بسیار مهم است. TensorRT با بهینهسازی مدلهای ادراک ربات، مانند تشخیص موانع، تخمین فاصله و برنامهریزی مسیر، به رباتها کمک میکند تا با چابکی و دقت بیشتری عمل کنند.

سیستمهای توصیه و تحلیل دادههای لحظهای 📈

پلتفرمهایی که به طور مداوم دادهها را پردازش کرده و توصیههایی را به کاربران ارائه میدهند (مانند پلتفرمهای پخش موسیقی یا فروشگاههای آنلاین)، برای حفظ رضایت کاربر، نیازمند استنتاج سریع هستند. TensorRT به این سیستمها کمک میکند تا پیشنهادهای شخصیسازی شده را در لحظه ارائه دهند.

تحولات در صنعت بازی و واقعیت مجازی 🎮

با افزایش پیچیدگی مدلهای گرافیکی و هوش مصنوعی در بازیها و تجربیات واقعیت مجازی، TensorRT نقش مهمی در ارائه تجربهای روان و بدون لگ ایفا میکند. این ابزار به بهینهسازی پردازشهای گرافیکی و منطق بازی کمک میکند.

پرسش و پاسخهای متداول در مورد TensorRT ❓

در ادامه به برخی از پرتکرارترین سؤالات کاربران در مورد NVIDIA TensorRT پاسخ میدهیم تا درک عمیقتری از این ابزار کاربردی پیدا کنید.

۱. آیا TensorRT فقط روی GPU های NVIDIA کار میکند؟

بله، TensorRT برای اجرا و بهینهسازی مدلها بر روی پردازندههای گرافیکی NVIDIA طراحی شده است.

۲. چه فریمورکهایی برای کار با TensorRT پشتیبانی میشوند؟

TensorRT از فریمورکهای محبوبی مانند TensorFlow، PyTorch، Caffe و همچنین فرمت ONNX پشتیبانی میکند.

۳. چگونه میتوانم مدل PyTorch خود را برای TensorRT آماده کنم؟

شما میتوانید مدل PyTorch خود را با استفاده از TorchScript یا تبدیل آن به فرمت ONNX، برای استفاده با TensorRT آماده سازید.

۴. مزیت اصلی استفاده از تقطیر (Quantization) در TensorRT چیست؟

تقطیر با کاهش دقت عددی، باعث کاهش حجم مدل، افزایش سرعت استنتاج و کاهش مصرف حافظه میشود، در حالی که افت دقت مدل معمولاً ناچیز است.

۵. آیا TensorRT برای همه مدلهای یادگیری عمیق مناسب است؟

TensorRT برای شتابدهی به استنتاج مدلهای شبکههای عصبی عمیق، به ویژه مدلهای مورد استفاده در کاربردهای عملی، بسیار مؤثر است.

۶. چه کسانی بیشترین بهره را از TensorRT میبرند؟

مهندسان هوش مصنوعی، توسعهدهندگان MLOps، و هر کسی که مسئولیت استقرار و اجرای سریع مدلهای یادگیری عمیق را بر عهده دارد، بیشترین بهره را از TensorRT خواهند برد.

۷. آیا استفاده از TensorRT پیچیده است؟

یادگیری اصول اولیه TensorRT ممکن است کمی زمانبر باشد، اما با ابزارها و مستندات موجود، فرآیند بهینهسازی و استقرار مدلها به طور قابل توجهی سادهتر میشود.

۸. چقدر میتوانم انتظار افزایش سرعت با TensorRT داشته باشم؟

میزان افزایش سرعت به عوامل مختلفی مانند پیچیدگی مدل، سختافزار GPU، و تنظیمات بهینهسازی بستگی دارد، اما اغلب چندین برابر افزایش سرعت را تجربه خواهید کرد.

۹. آیا TensorRT فقط برای استقرار در محیطهای ابری کاربرد دارد؟

خیر، TensorRT برای استقرار در طیف وسیعی از محیطها، از جمله سرورهای داخلی، دستگاههای لبه (Edge Devices) و حتی موبایل (با استفاده از TensorRT-LLM)، قابل استفاده است.

۱۰. تفاوت اصلی بین TensorRT و فرمت ONNX چیست؟

ONNX یک فرمت استاندارد برای نمایش مدلهای یادگیری عمیق است که قابلیت تبادل مدل بین فریمورکهای مختلف را فراهم میکند. TensorRT یک ابزار بهینهسازی و زمان اجرای (Runtime) مخصوص NVIDIA است که مدلها را برای اجرا با حداکثر کارایی روی GPU های NVIDIA بهینه میکند و میتواند مدلهای ONNX را نیز پردازش کند.

۱۱. آیا با استفاده از TensorRT، محدودیتهایی در معماری مدل ایجاد میشود؟

TensorRT از اکثر لایهها و عملیات رایج در شبکههای عصبی پشتیبانی میکند. اما در موارد نادر، ممکن است نیاز به سفارشیسازی یا جایگزینی برخی لایههای خاص باشد.

۱۲. چگونه میتوانم از بهینهسازی تقطیر INT8 در TensorRT استفاده کنم؟

برای استفاده از تقطیر INT8، معمولاً نیاز به کالیبراسیون مدل با دادههای نماینده دارید تا بهترین مقادیر آستانه برای کوانتیزاسیون تعیین شود.

۱۳. آیا TensorRT برای پردازش مدلهای بزرگ زبان (LLMs) نیز مناسب است؟

بله، NVIDIA ابزارهایی مانند TensorRT-LLM را توسعه داده است که به طور خاص برای بهینهسازی استنتاج مدلهای بزرگ زبان روی GPU های NVIDIA طراحی شدهاند.

۱۴. چه ابزارهایی برای تبدیل مدل به TensorRT وجود دارند؟

ابزارهایی مانند `trtexec` (برای تبدیل مستقیم مدلهای ONNX یا UFF) و `polygraphy` (برای مدیریت پیچیدهتر فرآیند تبدیل و اعتبارسنجی) در دسترس هستند.

۱۵. آیا یادگیری TensorRT نیاز به دانش برنامهنویسی پیشرفته دارد؟

در حالی که آشنایی با برنامهنویسی (به ویژه C++ و Python) برای استفاده حرفهای از TensorRT مفید است، مفاهیم اصلی و شروع کار با این ابزار قابل دستیابی برای علاقهمندان با دانش اولیه در یادگیری ماشین است.

نقد و بررسیها

هنوز بررسیای ثبت نشده است.